De Revolutie van Gedistribueerde Gegevensverwerking: Hoe 2025 Skalabiliteit, Real-Time Analytics en Bedrijfsflexibiliteit Zal Herdefiniëren. Verken de Technologieën en Marktkrachten die de Volgende Vijf Jaar Vormgeven.

- Executive Summary: Belangrijke Trends en Marktinvloeden in 2025

- Marktomvang, Groei Voorspellingen en CAGR Analyse (2025–2030)

- Kerntechnologieën: Cloud-Native, Edge en Serverless Architecturen

- Belangrijke Spelers en Ecosysteem Overzicht (bijv. Apache, Google, AWS, Microsoft)

- Opkomende Toepassingen: AI, IoT en Real-Time Analytics

- Regulatory Landscape en Uitdagingen voor Gegevensbeheer

- Concurrent Landschap: Open Source vs. Proprietaire Oplossingen

- Investeringen, M&A en Start-up Activiteiten in Gedistribueerde Gegevensverwerking

- Belemmeringen voor Acceptatie en Strategieën voor Bedrijfsintegratie

- Toekomstige Vooruitzichten: Innovaties, Ontwrichtingen en Strategische Aanbevelingen

- Bronnen & Verwijzingen

Executive Summary: Belangrijke Trends en Marktinvloeden in 2025

Gedistribueerde gegevensverwerkingsplatforms staan in 2025 aan de voorhoede van de digitale transformatie, aangedreven door de exponentiële groei van gegevensvolumes, de toename van edge-apparaten en de groeiende adoptie van kunstmatige intelligentie (AI) en machine learning (ML) workloads. Deze platforms stellen organisaties in staat om gegevens in real-time te verwerken, analyseren en erop te acteren in geografisch verspreide omgevingen, wat cruciale toepassingen in financiën, gezondheidszorg, productie en meer ondersteunt.

Een belangrijke trend in 2025 is de convergentie van cloud-native architecturen en gedistribueerde gegevensverwerking. Grote cloudaanbieders zoals Amazon Web Services, Microsoft Azure en Google Cloud blijven hun beheerde gedistribueerde gegevensdiensten uitbreiden, waaronder Apache Spark, Flink en proprietaire oplossingen. Deze aanbiedingen zijn steeds meer geïntegreerd met serverless computing en containerorkestratie, waarmee elastische schaling en vereenvoudigde operaties mogelijk worden gemaakt. De opkomst van hybride en multi-cloudstrategieën voedt ook de vraag naar platforms die naadloos gegevens kunnen verwerken in on-premises en cloud omgevingen.

Edge computing is een andere belangrijke drijfveer, aangezien organisaties gegevens dichter bij de bron willen verwerken om latentie en bandbreedtekosten te verlagen. Bedrijven zoals Red Hat en VMware investeren in gedistribueerde gegevensstructuren die zich uitstrekken van het datacenter naar de rand, en real-time analytics ondersteunen voor IoT, autonome voertuigen en slimme infrastructuur. Open-source projecten zoals Apache Kafka en Apache Pulsar blijven fundamenteel voor streamingdatapijplijnen, met commerciële ondersteuning en innovatie van leveranciers zoals Confluent.

Beveiliging, gegevensbeheer en naleving van regelgeving worden steeds centraler in de selectie en implementatie van platforms. Gedistribueerde gegevensverwerkingsplatforms evolueren om geavanceerde encryptie, fijnmazige toegangscontroles en geïntegreerde gegevensafkomsttracking aan te bieden om deze zorgen aan te pakken. Industrie-leiders werken samen met normenorganen om interoperabiliteit en naleving van wereldwijde gegevensbeschermingsregelingen te waarborgen.

Vooruitkijkend wordt verwacht dat de markt een voortdurende groei zal zien naarmate organisaties prioriteit geven aan real-time inzichten en automatisering. De integratie van AI/ML-mogelijkheden rechtstreeks in gedistribueerde gegevensplatforms versnelt, met bedrijven zoals Databricks en Cloudera die vooroplopen in verenigde analytics en data lakehouse-architecturen. Terwijl datastromen complexer worden, zal het vermogen om gedistribueerde verwerking te orkestreren en te optimaliseren in diverse omgevingen een belangrijke differentiator zijn voor platformleveranciers.

Marktomvang, Groei Voorspellingen en CAGR Analyse (2025–2030)

De markt voor gedistribueerde gegevensverwerkingsplatforms staat op het punt robuuste expansie te ondergaan tussen 2025 en 2030, aangedreven door de exponentiële groei van gegevensvolumes, de proliferatie van cloud-native architecturen en de toenemende adoptie van kunstmatige intelligentie (AI) en machine learning (ML) workloads. Terwijl organisaties in verschillende sectoren proberen real-time analytics te benutten en complexe, grootschalige datasets te beheren, worden oplossingen voor gedistribueerde gegevensverwerking fundamenteel voor digitale transformatiestrategieën.

Belangrijke industrie-leiders zoals Microsoft, Amazon (via Amazon Web Services) en Google (via Google Cloud Platform) blijven zwaar investeren in services voor gedistribueerde gegevensverwerking, waaronder beheerde aanbiedingen voor Apache Spark, Hadoop en Flink. Deze hyperscalers breiden hun wereldwijde infrastructuur uit en integreren geavanceerde analytics, beveiliging en orkestratiefuncties om tegemoet te komen aan de eisen van ondernemingen op het gebied van schaalbaarheid, betrouwbaarheid en naleving.

Open-source frameworks blijven centraal in de markt staan, met de Apache Software Foundation die de breed geaccepteerde projecten zoals Apache Spark, Apache Flink en Apache Kafka beheert. Deze technologieën vormen de basis voor vele commerciële en cloud-native oplossingen, waardoor organisaties streaming- en batchdata op grote schaal kunnen verwerken. De groeiende ecosysteem rond deze projecten, inclusief bijdragen van bedrijven zoals Databricks (een belangrijke contributor aan Spark) en Confluent (opgericht door de makers van Kafka), versnelt innovatie en adoptie door ondernemingen.

Vanuit een kwantitatief perspectief wordt verwacht dat de markt een samengestelde jaarlijkse groeipercentage (CAGR) in de hoge tien procent zal bereiken tot 2030, wat zowel de uitbreiding van cloudgebaseerde implementaties als de toenemende integratie van gedistribueerde verwerking in edge- en hybride omgeving weerspiegelt. De vraag naar real-time analytics, IoT-gegevensverwerking en AI/ML-modeltraining wordt verwacht een belangrijke groeimotor te zijn, met sectoren zoals financiële dienstverlening, gezondheidszorg, productie en telecommunicatie die de adoptie leiden.

Vooruitkijkend blijft de marktopdracht zeer positief. De convergentie van gedistribueerde gegevensverwerking met containerisatie (bijv. Kubernetes), serverless computing en data mesh-architecturen zal naar verwachting de groei verder versnellen en de barrières voor toegang voor organisaties van alle grootten verlagen. Strategische partnerschappen, voortdurende open-source innovatie en de uitbreiding van beheerde diensten door cloudaanbieders zullen naar verwachting het concurrentielandschap vormen tot 2030 en verder.

Kerntechnologieën: Cloud-Native, Edge en Serverless Architecturen

Gedistribueerde gegevensverwerkingsplatforms bevinden zich in het hart van moderne digitale infrastructuur, waardoor organisaties in staat worden gesteld om enorme hoeveelheden gegevens in real time te analyseren en erop te handelen. Vanaf 2025 ervaart de sector een snelle evolutie, aangedreven door de convergentie van cloud-native, edge en serverless architecturen. Deze kerntechnologieën herdefiniëren hoe gegevens worden ingevoerd, verwerkt en geleverd in verschillende sectoren.

Cloud-native gedistribueerde gegevensverwerkingsplatforms, zoals Amazon Web Services (AWS) EMR, Google Cloud Dataproc en Microsoft Azure Synapse Analytics, worden steeds vaker geprefereerd vanwege hun schaalbaarheid, flexibiliteit en integratie met beheerde diensten. Deze platforms maken gebruik van containerisatie en orkestratie (voornamelijk Kubernetes) om naadloze schaling en hoge beschikbaarheid mogelijk te maken. In 2025 breiden deze aanbieders de ondersteuning voor open-source frameworks zoals Apache Spark, Flink en Kafka uit, waardoor ondernemingen complexe, gedistribueerde datapijplijnen kunnen bouwen met minimale operationele overhead.

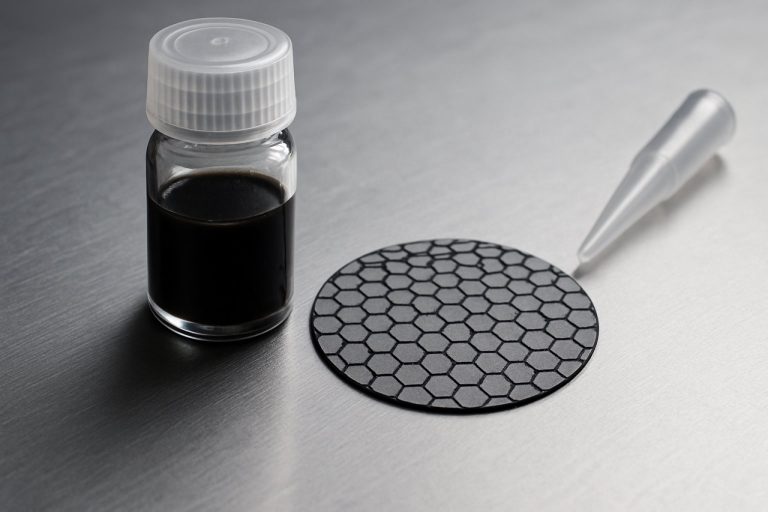

Edge computing is een andere transformerende kracht. Met de proliferatie van IoT-apparaten en de behoefte aan low-latency analytics, verschuift gedistribueerde gegevensverwerking dichter naar de gegevensbronnen. Bedrijven zoals Cisco Systems en Hewlett Packard Enterprise (HPE) investeren in edge-geoptimaliseerde platforms die real-time gegevensverwerking aan de netwerkrand ondersteunen. Deze oplossingen verlagen de bandbreedtekosten en stellen snellere besluitvorming mogelijk voor toepassingen in de productie, slimme steden en autonome voertuigen.

Serverless architecturen democratiseren verder de toegang tot gedistribueerde gegevensverwerking. Aanbiedingen zoals AWS Lambda, Google Cloud Functions en Azure Functions stellen ontwikkelaars in staat om evenementgestuurde gegevensverwerkingsworkloads uit te voeren zonder servers of infrastructuur te beheren. Dit model wint aan populariteit vanwege de kostenefficiëntie en het vermogen om automatisch te schalen in reactie op de vraag. In 2025 wordt serverless gegevensverwerking geïntegreerd met evenementstreaming en batchanalytics, waardoor organisaties gegevenspiekbelasting en continue streams met gelijke wendbaarheid kunnen verwerken.

Vooruitkijkend is de vooruitzicht voor gedistribueerde gegevensverwerkingsplatforms gekenmerkt door verhoogde interoperabiliteit, beveiligingsverbeteringen en AI-gedreven automatisering. Grote cloudproviders investeren in verenigde gegevensplatforms die cloud- en edge-omgevingen met elkaar verbinden, terwijl ze ook geavanceerde beveiligings- en compliance-functies integreren. De integratie van machine learning voor workloadoptimalisatie en anomaliedetectie wordt verwacht de efficiëntie en betrouwbaarheid van het platform verder te verbeteren. Terwijl de volumes en snelheid van gegevens blijven groeien, zullen gedistribueerde gegevensverwerkingsplatforms een fundamentele technologie blijven voor digitale transformatie in alle sectoren.

Belangrijke Spelers en Ecosysteem Overzicht (bijv. Apache, Google, AWS, Microsoft)

Het landschap van gedistribueerde gegevensverwerkingsplatforms in 2025 wordt gevormd door een dynamisch ecosysteem van belangrijke technologieproviders, open-source projecten en cloud hyperscalers. Deze platforms zijn essentieel voor organisaties die enorme datasets in real-time of batchmodus willen verwerken, analyseren en inzichten willen halen uit toepassingen van AI/ML tot IoT en business intelligence.

In het hart van het ecosysteem bevinden zich open-source frameworks zoals Apache Hadoop en Apache Spark, die nog steeds wijdverspreid worden gebruikt voor grootschalige gegevensverwerking. De Apache Software Foundation blijft deze projecten beheren, waarbij Spark in het bijzonder evolueert om geavanceerde analytics, streaming en integratie met cloud-native opslag te ondersteunen. Het Apache-ecosysteem omvat ook Flink, Kafka en Beam, elk gericht op specifieke behoeften in streamverwerking en gegevenspijplijn-orkestratie.

Cloudserviceproviders spelen een cruciale rol in de markt voor gedistribueerde gegevensverwerking. Amazon Web Services (AWS) biedt een uitgebreide suite van beheerde services, waaronder Amazon EMR (Elastic MapReduce) voor Hadoop- en Spark-workloads, en AWS Glue voor serverless gegevensintegratie. De wereldwijde infrastructuur van AWS en de integratie met andere cloud-native diensten maken het een voorkeurskeuze voor ondernemingen die hun gegevensoperaties willen opschalen.

Google Cloud maakt gebruik van zijn erfgoed in grootschalige gegevensverwerking, met producten zoals Dataproc (beheerd Spark en Hadoop), Dataflow (gebaseerd op Apache Beam) en BigQuery, een serverless data warehouse geoptimaliseerd voor gedistribueerde analytics. De focus van Google op AI/ML-integratie en open-source compatibiliteit blijft datagestuurde organisaties aantrekken.

Microsoft Azure’s gegevensplatform omvat Azure Synapse Analytics, dat big data en datawarehousing verenigt, en Azure Databricks, een samenwerkingsplatform op basis van Apache Spark. De nadruk van Microsoft op hybride en multi-cloud capaciteiten, evenals diepe integratie met ondernemingsproductiviteits-tools, positioneert het sterk in gereguleerde en grootschalige bedrijfsomgevingen.

Andere significante bijdragers zijn Databricks, het bedrijf achter het Unified Data Analytics Platform en een belangrijke kracht in de ontwikkeling van Spark, en Confluent, dat Apache Kafka commercialiseert voor real-time gegevensstreaming. Beide bedrijven breiden hun cloud-native aanbiedingen uit en investeren in AI-gedreven gegevensverwerkingsfuncties.

Vooruitkijkend wordt verwacht dat het ecosysteem voor gedistribueerde gegevensverwerking verder zal convergeren tussen batch- en streamverwerking, met een toenemende adoptie van serverless en gecontaineriseerde architecturen en diepere integratie met AI/ML-workflows. Open-source innovatie, gecombineerd met de schaal en flexibiliteit van cloudplatforms, zal blijven bijdragen aan snelle evolutie en concurrentie onder deze belangrijke spelers tot 2025 en verder.

Opkomende Toepassingen: AI, IoT en Real-Time Analytics

Gedistribueerde gegevensverwerkingsplatforms staan in het hart van de digitale transformatie die verschillende industrieën in 2025 overspoelt, en maken nieuwe en geavanceerde toepassingen mogelijk in kunstmatige intelligentie (AI), het Internet der Dingen (IoT) en real-time analytics. Deze platforms, ontworpen om enorme hoeveelheden gegevens te verwerken over geografisch verspreide nodes, zijn cruciaal voor organisaties die actionable insights willen halen uit de steeds groeiende datastromen.

In AI is gedistribueerde gegevensverwerking fundamenteel voor het trainen en toepassen van grootschalige machine learning-modellen. De opkomst van generatieve AI en grote taalmodellen heeft de vraag naar platforms verhoogd die efficiënt gegevens kunnen verwerken en verplaatsen tussen datacenters en edge-locaties. Databricks, een leider in verenigde analytics, blijft zijn gedistribueerde verwerkingscapaciteiten uitbreiden, ter ondersteuning van samenwerkende AI-ontwikkeling en real-time inferentie op schaal. Evenzo is Cloudera bezig zijn hybride gegevensplatform te verbeteren om naadloze gegevensbeweging en verwerking te mogelijk te maken in on-premises, cloud- en edge-omgevingen, een noodzaak voor AI-workloads die zowel hoge doorvoer als lage latentie vereisen.

De proliferatie van IoT-apparaten—die naar verwachting wereldwijd meer dan 30 miljard verbonden eenheden zal overschrijden tegen 2025—vereist robuuste gedistribueerde gegevensverwerking om de stortvloed aan sensorgegevens die aan de rand wordt gegenereerd te beheren. Platformen zoals De Apache Software Foundation’s Apache Kafka en Apache Flink worden veel gebruikt voor het binnenhalen, verwerken en analyseren van streamingdata in real time. Confluent, opgericht door de makers van Kafka, commercialiseert en breidt deze mogelijkheden verder uit, waardoor ondernemingen evenementgestuurde architecturen kunnen opbouwen die voorspellend onderhoud, slimme productie en verbonden voertuigecosystemen ondersteunen.

Real-time analytics is een ander gebied waar gedistribueerde gegevensverwerkingsplatforms onmisbaar zijn. Financiële diensten, telecommunicatie en e-commerce bedrijven maken gebruik van deze platforms om fraude te detecteren, klantervaringen te personaliseren en operaties onmiddellijk te optimaliseren. Snowflake is een belangrijke speler geworden, met een cloud-native gegevensplatform dat real-time gegevensdeling en analytics ondersteunt over meerdere clouds en regio’s. Ondertussen investeren Google en Microsoft zwaar in hun respectieve cloudgegevensdiensten, gecombineerd met gedistribueerde verwerking in real-time dashboards en AI-gestuurde inzichten.

Vooruitkijkend zal de convergentie van AI, IoT en real-time analytics de evolutie van gedistribueerde gegevensverwerkingsplatforms verder versnellen. Innovaties in edge computing, gefedereerd leren en data mesh-architecturen worden verwacht om latentie te verminderen, gegevensprivacy te verbeteren en meer autonome besluitvorming aan de rand mogelijk te maken. Terwijl organisaties blijven prioriteren op wendbaarheid en intelligentie, zal gedistribueerde gegevensverwerking een hoeksteen blijven van digitale infrastructuur in 2025 en verder.

Regulatory Landscape en Uitdagingen voor Gegevensbeheer

Het regelgevende landschap voor gedistribueerde gegevensverwerkingsplatforms evolueert snel in 2025, aangedreven door de proliferatie van cloud-native architecturen, grensoverschrijdende gegevensstromen en de toenemende adoptie van kunstmatige intelligentie (AI) en machine learning (ML) op schaal. Terwijl organisaties gebruikmaken van gedistribueerde platforms zoals Apache Hadoop, Apache Spark en cloud-native diensten van grote aanbieders, hebben ze te maken met toenemende uitdagingen om te voldoen aan de diverse en steeds striktere gegevensbeheer vereisten wereldwijd.

Een belangrijke regelgevende trend is de wereldwijde uitbreiding van gegevensbeschermingswetten. De Algemene Verordening Gegevensbescherming (AVG) van de Europese Unie blijft een hoge standaard stellen voor gegevensprivacy en beïnvloedt vergelijkbare kaders in regio’s zoals Latijns-Amerika, het Midden-Oosten en de Azië-Pacific. In de Verenigde Staten worden staatsregelingen—met name de California Consumer Privacy Act (CCPA) en de daaropvolgende wijzigingen—voorgesteld om door nieuwe staatswetten te worden aangevuld, wat de complexiteit vergroot voor gedistribueerde gegevensverwerkingsplatforms die over jurisdicties opereren. Deze regelgevingen vereisen robuuste mechanismen voor gegevenslokalisatie, toestemmingsbeheer en het recht op verwijdering, die allemaal technisch uitdagend zijn in gedistribueerde omgevingen.

Grote cloudproviders, waaronder Amazon Web Services, Microsoft Azure en Google Cloud, reageren door hun gegevensbeheer-toolkits te verbeteren. Deze omvatten geautomatiseerde gegevensclassificatie, encryptie en beleidsafhandelingsfuncties die klanten helpen aan hun nalevingsverplichtingen te voldoen. Deze bedrijven bieden nu ook regio-specifieke opties voor gegevensverblijf en geavanceerde auditlogging aan ter ondersteuning van regelgevende rapportage en incidentrespons. Open-source projecten zoals Apache Ranger en Apache Atlas worden ook geïntegreerd in bedrijfsdatastacken om fijnmazige toegangscontrole en metadata-beheer te bieden.

Een belangrijke uitdaging in 2025 is het beheer van gegevens in hybride en multi-cloud omgevingen. Terwijl organisaties workloads verdelen over on-premises infrastructuur en meerdere cloudaanbieders, wordt het steeds complexer om consistente beleidsafhandeling en zichtbaarheid te waarborgen. Brancheorganisaties zoals de International Organization for Standardization (ISO) werken aan het updaten van normen (bijv. ISO/IEC 27001) om deze nieuwe realiteiten aan te pakken, terwijl de Cloud Security Alliance beste praktijken publiceert voor veilige en conforme gedistribueerde gegevensverwerking.

Vooruitkijkend wordt het vooruitzicht voor gedistribueerde gegevensverwerkingsplatforms gevormd door de convergentie van regelgevende druk en technologische innovatie. De komende jaren zullen waarschijnlijk een toename in automatisering in gegevensbeheer met zich mee brengen, met AI-gedreven tools voor anomaliedetectie, beleidsafhandeling en realtime nalevingsmonitoring. De snelheid van regelgevende veranderingen en de technische complexiteit van gedistribueerde systemen betekenen echter dat organisaties waakzaam moeten blijven en moeten investeren in zowel technologie als expertise om het evoluerende landschap te navigeren.

Concurrent Landschap: Open Source vs. Proprietaire Oplossingen

HetConcurrent landschapslandschap voor gedistribueerde gegevensverwerkingsplatforms in 2025 wordt gedefinieerd door een dynamisch samenspel tussen open-source frameworks en proprietaire oplossingen. Open-source projecten zoals Apache Hadoop, Apache Spark en Apache Flink blijven fungeren als fundamentele technologieën voor grootschalige gegevensanalyse, machine learning en real-time streamverwerking. Deze platforms worden beheerd door de Apache Software Foundation, die zorgt voor gemeenschapsgedreven ontwikkeling, transparantie en brede toegankelijkheid. Hun modulaire architecturen en uitgebreide ecosystemen maken ze de ruggengraat van gegevensinfrastructuur voor ondernemingen die flexibiliteit en kostenefficiëntie zoeken.

Aan de zijde van de proprietary oplossingen hebben grote cloudaanbieders hun beheerde gedistribueerde gegevensverwerkingsaanbiedingen aanzienlijk uitgebreid. Amazon Web Services (AWS) biedt Amazon EMR en AWS Glue, die schaalbare, volledig beheerde omgevingen bieden voor het uitvoeren van open-source frameworks met enterprise-grade beveiliging en integratie. Microsoft levert Azure Synapse Analytics en Azure Databricks, waarbij de laatste een samenwerkingsplatform is dat in samenwerking met Databricks is gebouwd, een bedrijf dat is opgericht door de oorspronkelijke makers van Apache Spark. Google biedt Google Cloud Dataflow en Dataproc, met de focus op naadloze integratie met zijn cloud-native ecosysteem en AI-diensten.

De discussie over open source versus proprietary oplossingen wordt steeds genuanceerder. Open-source platforms bieden transparantie, gemeenschapssteun en de mogelijkheid om vendor lock-in te vermijden, wat aantrekkelijk blijft voor organisaties met interne expertise en complexe, hybride omgevingen. Echter, proprietaire oplossingen winnen aan terrein door operationele complexiteit te abstraheren, robuuste SLA’s te bieden en geavanceerde functies zoals geautomatiseerde schaling, beveiliging en AI-gedreven optimalisaties te integreren. Deze beheerde diensten zijn bijzonder aantrekkelijk voor ondernemingen die wendbaarheid en snelle innovatie boven gedetailleerde controle stellen.

De laatste jaren is er een trend zichtbaar naar hybride modellen, waarbij proprietaire leveranciers beheerde diensten aanbieden op basis van open-source motoren, en zo het beste van beide werelden combineren. Bijvoorbeeld, Databricks en Confluent (voor Apache Kafka) bieden commerciële platforms die open-source technologieën verbeteren met enterprise-functies, ondersteuning en cloud-native mogelijkheden. Deze aanpak zal naar verwachting intensiveren tot 2025 en verder, naarmate organisaties streven naar een balans tussen innovatie, kosten en operationele eenvoud.

Vooruitkijkend zal het concurrentielandschap waarschijnlijk worden gevormd door vooruitgangen in AI-integratie, multi-cloud interoperabiliteit en het groeiende belang van gegevensbeheer en privacy. Zowel open-source gemeenschappen als proprietaire verkopers investeren zwaar in deze gebieden, wat wijst op voortdurende evolutie en convergentie in gedistribueerde gegevensverwerkingsplatforms.

Investeringen, M&A en Start-up Activiteiten in Gedistribueerde Gegevensverwerking

De sector van gedistribueerde gegevensverwerkingsplatforms ervaart robuuste investeringen, M&A en start-up activiteiten naarmate organisaties de kracht van big data, AI en real-time analytics willen benutten. In 2025 wordt de markt gevormd door de convergentie van cloud-native architecturen, open-source frameworks en de toenemende vraag naar schaalbare, low-latency gegevensverwerkingsoplossingen.

Grote cloudaanbieders blijven aanzienlijke investeringen doen in gedistribueerde gegevensverwerking. Amazon Web Services (AWS) heeft zijn portfolio uitgebreid met diensten zoals Amazon EMR en AWS Glue, ter ondersteuning van zowel batch- als streaming workloads. Microsoft Azure en Google Cloud hebben hun aanbiedingen op vergelijkbare wijze verbeterd, met respectievelijk Azure Synapse Analytics en Google Dataflow, en integratie van geavanceerde analytics en machine learning mogelijkheden. Deze hyperscalers investeren niet alleen in de ontwikkeling van de platforms, maar verwerven ook start-ups om hun technologie-stacks en talentpools te versterken.

De M&A-activiteit blijft bruisend, met gevestigde spelers die innovatieve start-ups overnemen om een versnelde productontwikkeling en uitbreiding in nieuwe verticalen te bereiken. Bijvoorbeeld, Databricks, een leider in verenigde analytics en de primaire commerciële sponsor van Apache Spark, heeft zijn acquisitiestrategie voortgezet en richt zich op bedrijven die gespecialiseerd zijn in gegevensbeheer, real-time verwerking en AI-integratie. Confluent, dat is opgebouwd rond Apache Kafka, heeft ook overnames nagestreefd om zijn evenementstreamingplatform uit te breiden, met een focus op beveiliging en multi-cloudmogelijkheden.

Venture capital-investeringen in start-ups voor gedistribueerde gegevensverwerking blijven sterk in 2025, met een focus op bedrijven die volgende generatie gegevensorkestratie, observability en privacy-behoudende analytics ontwikkelen. Start-ups zoals Starburst (dat Trino/Presto commercialiseert voor gefedereerde query-engines) en Snowflake (cloud gegevensplatform met gedistribueerde architectuur) hebben aanzienlijke financieringsrondes aangetrokken, wat het vertrouwen van investeerders in de groeitraject van de sector weerspiegelt. Open-source projecten blijven een vruchtbare bodem voor innovatie, met commerciële entiteiten die opkomen om enterprise-ondersteuning en beheerde diensten te bieden.

Vooruitkijkend blijft de vooruitzicht voor investeringen en M&A in gedistribueerde gegevensverwerkingsplatforms positief. De proliferatie van edge computing, IoT en AI-gedreven toepassingen wordt verwacht een verdere vraag naar schaalbare, gedistribueerde oplossingen te stimuleren. Terwijl de volumes en complexiteit van gegevens toenemen, zijn zowel gevestigde leveranciers als flexibele start-ups in een goede positie om te profiteren van aanhoudende digitale transformatiesinitiatieven in verschillende sectoren.

Belemmeringen voor Acceptatie en Strategieën voor Bedrijfsintegratie

De adoptie van gedistribueerde gegevensverwerkingsplatforms in ondernemingen versnelt in 2025, aangedreven door de behoefte om steeds groeiendere gegevensvolumes te beheersen en real-time analytics te ondersteunen. Er blijven echter enkele barrières bestaan die wijdverbreide integratie in de weg staan, zelfs terwijl toonaangevende technologieproviders innoveren om deze problemen aan te pakken.

Een primaire barrière is de complexiteit van het integreren van gedistribueerde gegevensverwerkingsplatforms met legacy-systemen. Veel ondernemingen werken met een mix van on-premises en cloudinfrastructuur, wat naadloze gegevensbeweging en verwerking bemoeilijkt. Compatibiliteitsproblemen, datasilo’s en de noodzaak voor gespecialiseerde vaardigheden om platforms zoals Cloudera en Databricks te beheren, kunnen de adoptie vertragen. Bovendien vereist de snelle evolutie van open-source frameworks zoals Apache Spark en Flink voortdurende training en aanpassing, wat een druk op IT-resources kan leggen.

Gegevensbeveiliging en naleving vormen ook een aanzienlijke uitdaging. Gedistribueerde architecturen vergroten inherent het aanvalsoppervlak, waardoor de zorgen over gegevensprivacy, naleving van regelgeving en veilige gegevensoverdracht over nodes en regio’s toenemen. Ondernemingen moeten ervoor zorgen dat platforms voldoen aan normen zoals de AVG en HIPAA, wat complex kan zijn wanneer gegevens over meerdere jurisdicties worden verwerkt. Leveranciers zoals IBM en Microsoft investeren in geavanceerde encryptie, toegangscontroles en nalevingscertificeringen om ondernemingen te helpen bij deze zorgen.

Kostenbeheer is ook een opvallende hindernis. Terwijl gedistribueerde platforms schaalbaarheid en efficiëntie beloven, kunnen onvoorspelbare workloads en gegevensoverdrachtskosten—vooral in hybride en multi-cloudomgevingen—leiden tot budgetoverschrijdingen. Ondernemingen zoeken naar transparantere prijsmodellen en geautomatiseerde optimalisatietools voor middelen, een focusgebied voor cloudleiders zoals Amazon (AWS) en Google (Google Cloud).

Om deze barrières te overwinnen, nemen ondernemingen verschillende strategieën aan. Allereerst maken velen gebruik van beheerde diensten en platform-as-a-service (PaaS) aanbiedingen om operationele complexiteit te verminderen en de inzet te versnellen. Bijvoorbeeld, Databricks en Cloudera bieden volledig beheerde cloudplatforms die veel van het onderliggende infrastructuurbeheer abstraheren. Ten tweede investeren organisaties in het bijscholen van personeel en cross-functionele teams om de talentkloof te overbruggen. Ten derde helpt de adoptie van gestandaardiseerde API’s en gegevensbeheerframeworks om integratie te stroomlijnen en naleving te waarborgen.

Vooruitkijkend is het vooruitzicht voor de integratie van gedistribueerde gegevensverwerkingsplatforms in ondernemingen positief. Naarmate leveranciers blijven werken aan de verbetering van interoperabiliteit, beveiliging en automatisering, en naarmate ondernemingen rijpen in hun datastrategieën, worden de adoptiebarrières verwacht te verminderen. De komende jaren zullen waarschijnlijk een verhoogde standaardisering, bredere ondersteuning voor hybride en multi-cloud implementaties, en een grotere nadruk op AI-gedreven optimalisatie met zich meebrengen, waardoor gedistribueerde gegevensverwerking verder wordt verankerd in de kern van digitale transformatie in ondernemingen.

Toekomstige Vooruitzichten: Innovaties, Ontwrichtingen en Strategische Aanbevelingen

Het landschap van gedistribueerde gegevensverwerkingsplatforms staat op het punt significante transformaties te ondergaan in 2025 en de komende jaren, gedreven door snelle vooruitgang in cloud-native architecturen, integratie van kunstmatige intelligentie (AI) en de proliferatie van edge computing. Terwijl organisaties blijven genereren en analyseren van enorme hoeveelheden gegevens, neemt de vraag naar schaalbare, veerkrachtige en intelligente gegevensverwerkingsoplossingen toe.

Belangrijke industrie-leiders zoals Microsoft, Amazon en Google versnellen de innovatie in deze ruimte via hun respectieve cloudplatforms—Azure, AWS en Google Cloud. Deze bedrijven investeren zwaar in serverless gegevensverwerking, real-time analytics en beheerde gedistribueerde frameworks zoals Apache Spark, Flink en Beam. Bijvoorbeeld, Amazon blijft zijn AWS Glue en EMR-aanbiedingen uitbreiden, met een focus op naadloze integratie met AI/ML-diensten en ondersteuning voor hybride en multi-cloud implementaties. Evenzo verbetert Microsoft Azure Synapse Analytics met functies die big data en datawarehousing verenigen, terwijl Google Dataflow en BigQuery verder ontwikkelt voor real-time, gedistribueerde analytics.

Een grote ontwrichting aan de horizon is de convergentie van gedistribueerde gegevensverwerking met AI en machine learning. Platforms integreren steeds vaker AI-gedreven automatisering voor gegevensorkestratie, anomaliedetectie en optimalisatie van middelenallocatie. Deze trend wordt verwacht operationele complexiteit te verminderen en organisaties in staat te stellen actionable insights sneller te verkrijgen. Bovendien dringt de opkomst van edge computing—gestuwd door bedrijven zoals IBM en Cisco—gedistribueerde gegevensverwerking dichter naar gegevensbronnen, wat lage-latentie analytics voor IoT, productie en slimme stadtoepassingen mogelijk maakt.

Open-source ecosystemen blijven een hoeksteen van innovatie. De Apache Software Foundation blijft projecten zoals Apache Kafka, Spark en Flink beheren, die wijdverbreid worden aangenomen door ondernemingen voor het bouwen van robuuste, schaalbare datapijplijnen. De samenwerking tussen cloudproviders en open-source gemeenschappen wordt verwacht te intensiveren, wat de interoperabiliteit bevordert en de adoptie van nieuwe standaarden versnelt.

Strategisch gezien wordt organisaties geadviseerd om prioriteit te geven aan platformflexibiliteit, gegevensbeheer en beveiliging terwijl ze hun data-architecturen moderniseren. Het omarmen van hybride en multi-cloudstrategieën zal cruciaal zijn om vendor lock-in te vermijden en de continuïteit van het bedrijf te waarborgen. Verder zal investeren in talentontwikkeling voor gedistribueerde systemen en AI essentieel zijn om het volgende niveau van gegevensverwerkingsplatforms volledig te benutten.

Samengevat zal de toekomst van gedistribueerde gegevensverwerkingsplatforms worden gevormd door cloud-native innovatie, AI-integratie en de uitbreiding van edge analytics. Ondernemingen die proactief inspelen op deze trends, zullen het best gepositioneerd zijn om de volledige waarde van hun gegevensactiva te benutten in een steeds digitalere en gedecentraliseerde wereld.